Technisches SEO - Warum wird meine Webseite nicht indexiert?

Indexierung bei Google

Eine erste Voraussetzung für ein gutes Ranking bei der Google Suche ist, dass die Seite überhaupt indexiert wird. Wenn das nicht der Fall ist, werden Webmaster berechtigter Weise nervös. Hier geht es um mögliche Fehlerquellen und die Tools, mit denen Du die Fehler finden kannst. Vom Grundsatz her braucht die Indexierung bei Google drei Voraussetzungen:

- Guten hochwertigen Inhalt

- Eine gute Nutzererfahrung

- Eine technisch saubere und schnelle Seite

Sind diese drei Voraussetzungen erfüllt, spricht nichts gegen eine Indexierung.

Ein häufiger Einwand bei einer Nicht-Indexierung ist, dass andere Suchmaschinen die Seite ja auch indexieren und dass die Seite dort gut rankt. Diese anderen Suchmaschinen sind aber nicht vergleichbar, da jede Suchmaschine mit Crawlern die Webseiten "besucht" und analysiert und nach den eigenen Kriterien beurteilt.

Google Crawler anstoßen

Das wichtigste Tool zur Prüfung und Fehlerfindung ist die Google Search Console. Nach einer Anmeldung undErstellungung einer Property kann man die Webseite dort auch prüfen und indexieren lassen.

Wichtig ist die zur Propterty passende Eingabe der URL. Wenn die URL noch nicht im Index ist, bekommst Du eine entsprechende Meldung und kannst dann das Crawlen anstoßen. Man braucht dann meistens ein paar Tage Geduld, bis die URL im Index ist und das auch bei einer erneuten Prüfung angezeigt wird.

Beachte noch: Man hat pro Tag nur eine begrenzte Zahl von Crawlinganträgen. Ggf. muss man dann 24 Stunden warten, bis man einen neuen Antrag stellen kann.

Prüfen der Indexierung

Es gibt zwei Methoden der Indexierungsprüfung, eine schnelle und eine etwas genauere:

- site - Abfrage

- Google Search Console

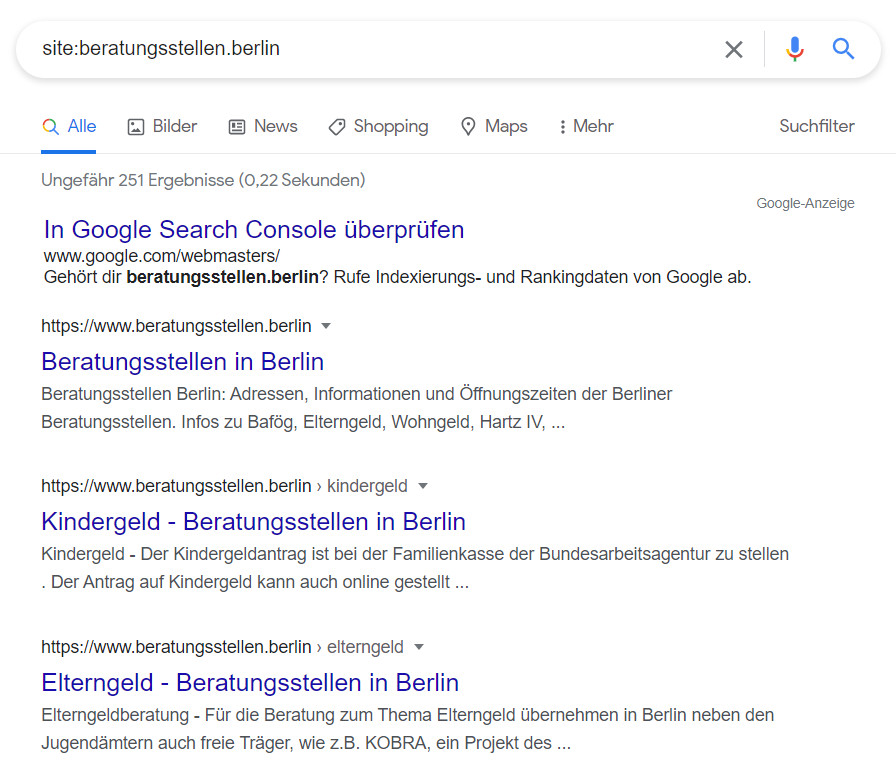

Die site - Abfrage

Bei der Site Abfrage gibts Du einfach ins Google Suchfeld site:deinedomain.de ein und Du bekommst angezeigt, welche URLs der Seite indexiert sind. Schön ist auch, dass Du in etwa siehst, wie die Seiten in der Suche angezeigt werden. (Da die Suchergebnisse immer auch von der Suchanfrage abhängig sind, kann es da zu Abweichungen kommen.) Der Nachteil dieser Prüfungsmethode ist, dass sie nicht immer zu 100% stimmt.

Alternativ zur site-Abfrage kannst Du auch versuchen einen kleineren Textabschnitt in Anführungszeichen als exakte Suchanfrage zu verwenden. Ggf. kannst Du so dann auch prüfen, ob Deine Seite schon im Index ist.

Indexierung mit der Search Console

Exakter ist in der Regel die URL-Prüfung mit der Search Console.

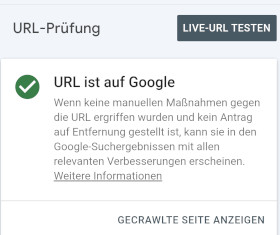

Wenn alles passt und die URL im Index ist, sieht es dann so aus:

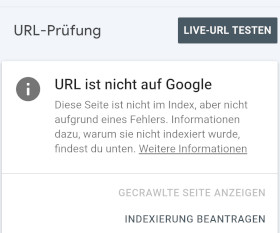

Wenn die URL noch nicht im Index ist, bekommst Du die folgende Meldung:

Du kannst dann die Indexierung beantragen oder über 'Weitere Informationen' bekommst Du ggf. Infos, warum die URL (noch) nicht im Index ist. Dabei muss man wissen, dass die Search Console kein Echtzeit-Tool ist und dass sowohl die Indexierung als auch die entsprechende Anzeige in der Search Console länger dauern kann. Manchmal hilft dann ein Blick auf die oben beschriebene site-Abfrage.

Eine weitere Methode in der Search Console ist die Einreichung einer Sitemap. Diese Methode spielt, insbesondere für kleinere Webseiten, in der Praxis keine Rolle mehr. Für Google reicht in der Regel eine gute interne Verlinkung aus, um die Seiten zu finden und zu indexieren.

Exkurs: Die richtige Property verwenden

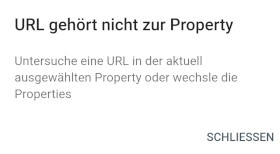

Es könnte auch sein, dass Du bei der Indexierungsprüfung in der Search Console die Meldung bekommst, dass ein Umleitungsfehler vorliegt oder dass die URL nicht zur Property gehört:

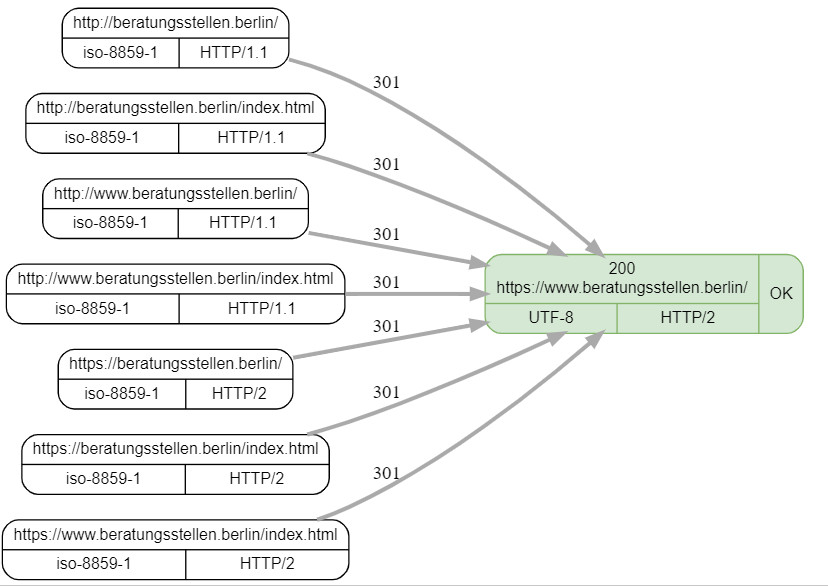

Hier muss ich zur Erläuterung ein bisschen ausholen. Wenn man von weiteren Subdomains absieht, gibt es für eine Domain vier Möglichkeiten, wie die URL dargestellt werden kann:

- http://meinedomain.de

- http://www.meinedomain.de

- https://meinedomain.de

- https://www.meinedomain.de

Https sollte heute Standard sein (unverschlüsselte Seiten werden von Google als Signal für fehlende Nutzerfreundlichkeit gewertet!), so dass Du Dich entscheiden solltest, ob Du eine URL mit oder ohne www nutzen willst. Dass kann dann über eine 301 Weiterleitung in der .htaccess realisiert werden. Wenn Du nicht weißt, welche Domain Du nutzt, gibt es ein nützliches kostenloses Test-Tool:

www.seotest.at

Auf diesem kannst Du sehen, auf welche Domain Deine Seite weiterleitet. Idealer Weise werden alle auf eine Version weitergeleitet. Und es macht Sinn diese Version als URL-Präfix-Property in der Search Console anzulegen. Die Alternative Domain-Property würde ich nicht empfehlen, da sie weniger Bestätigungsmethoden anbietet, einige Webmaster Tools damit nicht funktionieren und auch bei der Indexierung unter bestimmten Voraussetzungen ein wohl nicht vorhandener Umleitungsfehler angezeigt wird.

Wenn Du die passende URL-Präfix-Property angelegt hast, wird Dir die oben genannte Fehlermeldung nicht angezeigt. Ggf. kannst Du die falsche Property löschen und die passende neu anlegen.

Faktoren, die die Indexierung verhindern

Es gibt einige harte Faktoren, die eine Indexierung einfach verhindern. D.h. wenn bestimmte Dinge nicht funktionieren, dann kann oder will Google die Webseite nicht in den Index aufnehmen.

Aussperren des Smartphone-Crawlers

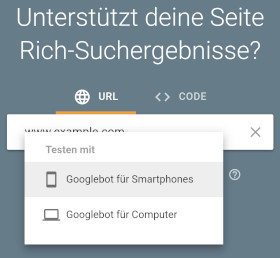

Mobil-first: Das ist seit einigen Jahren die Realität des Internet und somit ist der Smartphone Crawler von Google auch für die Indexierung wesentlich. Wenn der Smartphone Crawler keinen Zugriff auf die Seite hat, wird die Indexierung auch verhindert. Zur Überprüfung nutze ich einTool,das eigentlich für den Test von strukturierten Daten konzipiert ist. Jedoch kann man auch sehen, ob der Googlebot für Smartphones blockiert wird:

Falls der Mobil Crawler ausgesperrt wird, bekommst Du eine entsprechende Fehlermeldung. Die Ursache dafür kann in der robots.txt, der .htaccess oder in einer falschen Serverkonfiguration liegen. Ggf. kann der Hoster einen bei der Fehlersuche unterstützen.

Meta Tag Noindex

Über den meta tag noindex, der in den Head Bereich einer Webseite eingebunden wird, kann man dem Crawler sagen, dass die Seite nicht indexiert werden soll. Das kann sinnvoll sein, um z.B. das Indexierungsbudget zu schonen oder auch um Duplicate Content zu vermeiden. Wenn das aber unbewusst oder aus Versehen passiert, wird die Seite einfach nicht indexiert.

Um sicher zu gehen, dass Deine Seite nicht davon betroffen ist, kannst Du den Quellcode der Seite über eine Suchfunktion nach dem meta tag noindex durchsuchen und den tag entsprechend ändern. Der richtige tag sieht dann so aus:

<meta name="robots" content="index, follow" />

Damit kann die Seite indexiert werden und der Crawler kann den Links auf der Seite folgen.

robots.txt

Die Aufgabe der Datei robots.txt ist es, den Crawlern der Suchmaschinen mitzuteilen, welche Seiten gecrawlt werden dürfen. Ein Fehler in der robots.txt kann die Indexierung der gesamten Website oder einzelner Teile verhindern. Zwei Fehlerquellen sind hier zu nennen:

- Die robots.txt ist nicht korrekt erreichbar

- Der Code der Datei verhindert das Crawling gewünschter Seiten

Im ersten Fall ist es besonders problematisch, wenn der Server beim Aufruf die Fehlerkennung 500 (Internal Server Error) oder 403 (Error 403 Forbidden) zurückgibt. Der Google-Crawler interpretiert diese Fehler als Crawling-Verbot, so dass eine Indexierung der Seite nicht möglich ist. Ist keine robots.txt hinterlegt oder wird die Fehlermeldung 404 (File not available) zurückgegeben, interpretiert der Crawler dies so, dass keine Einschränkungen vorliegen. Insofern ist das dann kein Problem für die Indexierung. Der Klarheit halber würde ich aber immer auch eine robots.txt hinterlegen. Wichtig: Die Datei muss im Root-Verzeichnis liegen!

Ein Fehler im Code kann ebenso ungewollt zu einer Sperrung und Nicht-Indexierung einer Webseite oder von Teilen führen. Die möglichen Befehle wie allow und disallow sind nicht intuitiv zu begreifen und die Anweisungen folgen strikten Regeln. Im Web gibt es neben robots.txt Generatoren auch zahllose Anleitungen und Erklärungen. Wer sich näher damit beschäftigen will, dem empfehle ich folgende Seite:

robots.txt Datei erstellen

Das Google Test-Tool der alten Search Console wurde am 12. 12. 2023 eingestellt. Als Alternative gibt es jetzt in der Search Console unter 'Einstellungen' einen Report mit folgenden Auswertungen:

- Status

- Letzte Prüfung

- Größe

- Probleme

Außerdem kannst Du den Code und frühere Versionen abrufen und das Crawlen der robots.txt erneut beantragen. Du erhältst dann folgende Meldung:

Leider ist es nicht mehr möglich, eine bestimmte URL zu testen.

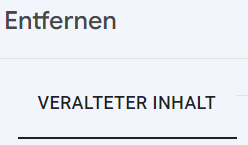

Entfernen von Inhalten

Ein Fehler bzw. Missverständnis kann auch eine Indexierung verhindern und oft ist dieser Fehler nur schwer zu finden. Manchmal möchtest Du vielleicht alte Seiten entfernen und sie mit neuem Inhalt füllen. In der Search Console hast Du dazu das Tool 'Entfernen' gefunden.

Aber Achtung: Wenn Du die gleiche URL dann für den neuen Inhalt nutzen willst, wird diese URL nicht indexiert! Dafür ist dieses Tool nicht gedacht. Du kannst dann den Antrag wieder löschen und danach über die URL-Prüfung die Indexierung noch einmal manuell anstoßen.

Weitere technische Probleme

Eine Webseite muss erreichbar sein. Falls technische Probleme der Seite oder des Servers die Erreichbarkeit einschränken, wird die Webseite auch nicht indexiert. Hinweise darauf gibt ggf. auch das schon oben genannten URL-Prüftool der Search Console. Ein weiterer Grund könnte eine fehlerhafte .htaccess Datei sein. Mit dieser kann man, ähnlich wie mit der robots.txt, bestimmte Bereiche der Webseite und auch der Zugriffe ausschließen. Fehler in der .htaccess werden in der Regel nicht "verziehen", man muss da genau wissen was man macht. Eine gute Einführung zum Thema .htaccess habe ich hier gefunden:

.htaccess - Einführung

Insgesamt sollte die Seite, insbesondere auch die Navigation und die Links technisch funktionieren. Broken Links und eine defekte Navigation lassen die Seite als eine "Baustelle" erscheinen. Falls Du noch nicht fertig mit der Erstellung der Webseite bist, ist es besser noch die Endarbeiten abzuschließen als mit einer Version 0.7 herauszugehen.

Auch wenn eine Seite zu lange im Wartungsmodus ist, den manche CMS Systeme anbieten, kann sich das negativ auf die Indexierung auswirken.

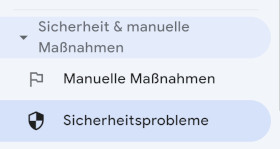

Manuelle Maßnahmen und Sicherheitsprobleme

Um gute, nützliche Ergebnisse in den Suchergebnissen zu sichern, hat Google eine ganze Reihe vonRichtlinienveröffentlicht. Mit den Qualitätsrichtlinien sollen u.a. Spam, bezahlte Links, kopierte Inhalte, Inhalte ohne Mehrwert und vieles andere mehr verhindert werden. Ziel ist es, dass man durch unseriöse Methoden gute Plätze in den Suchergebnissen belegt. Ebenso sollen Sicherheitsprobleme durch Malware oder gehackte Webseiten verhindert werden.

Google überprüft die Seiten entsprechend, sie werden ggf. nicht indexiert. Die Webmaster bekommen dann in der Search Console einen entsprechenden Hinweis. Deshalb ist bei Nicht-Indexierung immer ein Blick in die Search Console sinnvoll:

Wenn alles in Ordnung ist, gibt es (hoffentlich) diese Meldung:

Auch für die Sicherheitsprobleme gibt es diese Meldung. Falls Probleme vorhanden sind, müssen diese beseitigt werden. Man kann dann Google darüber informieren und die Webseite kann sich ggf. erholen.

Geringe Nutzerfreundlichkeit und Core Web Vitals

Neben den genannte harten Faktoren gibt es auch Faktoren, die nicht so eindeutig die Indexierung verhindern. In diesen Fällen dauert es evtl. länger, bis eine Seite in den Index aufgenommen wird oder Google "überlegt" noch, ob die Seite geeignet ist. Der Status ist dann meistens "Gecrawlt - zurzeit nicht indexiert" oder auch "Gefunden - zurzeit nicht indexiert".

Man kann in dem Moment hoffen, dass die Seite doch noch indexiert wird. Das kann durchaus mehrere Monate dauern. Oder Du versuchst die kritischen Punkte zu identifiziere und zu verbessern. Eine erste Adresse dafür sind die Core Web Vitals, die zusätzlich auch Einfluss auf das Ranking der Seite haben.

Mobil und Pagespeed

Wie schon oben beim Ausschluss des smartphone crawlers beschrieben, ist die mobile Nutzerfreundlichkeit für Google maßgeblich. Es führt da kein Weg mehr daran vorbei, da die mobile Nutzung des Internet schon über 80% ausmacht. Eine Webseite, die nicht mobil optimiert ist, entspricht nicht dem Qualitätsanspruch von Google.

Auch die Geschwindigkeit der Seite gehört zu den wichtigen Faktoren einer Webseite und zu den Qualitätsstandards insbesondere für die mobilen Seiten. Da das Zusammenspiel von Hoster, Webserver und Quellcode der Webseite die Geschwindigkeit und Nutzerfreundlichkeit bestimmen, ist dieser Aspekt technisch nicht ganz einfach und hat eine hohe Komplexität. Als Test-Tool eignet sich Pagespeed Insights:

Tool: PageSpeed Insights

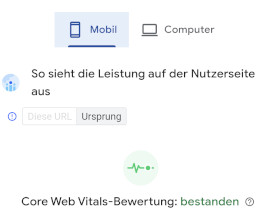

Das Tool analysiert sowohl die mobile als auch die Desktop Leistungsfähigkeit Deiner Seite bzw. Deines Hostings oder Webservers. Besonders wichtig sind die mobilen Ergebnisse, da die Anforderungen durch die Begrenzungen der mobilen Datenübertragung besonders hoch sind. Dabei werden auch Ergebnisse aus der tatsächlichen Nutzung der Webseite angezeigt, wenn genügend Daten dafür vorliegen. Die Daten werden von einer realen Nutzung mit dem Chrome-Browser erhoben und ergeben die Core Web Vitals. Idealer Weise hast Du ein solches Ergebnis:

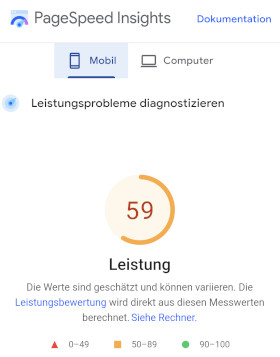

Weiter unten findest Du die Ergebnisse des Labortests. Eine Kennzahl zeigt Dir die Leistungsfähigkeit der Seite in drei Kategorien:

- grün: 90 - 100

- orange: 50 - 89

- rot - 0 - 49

Spätestens wenn Dein Ergebnis im roten Bereich ist, solltest Du Optimierungen vornehmen. Falls Du Probleme mit der Indexierung hast, ist ein "rotes Ergebnis" evtl. ein Indiz für eine Ursache. Hier Ein Beispiel für ein "orangenes Ergebnis",

Die Core Web Vitals haben nicht nur einen Einfluss ob und wann eine Seite indexiert wird, sondern seit 2022 auch auf das Ranking. Sie sind somit einer der vielen Faktoren, der eine gute Positionierung in den Suchergebnissen ermöglichen bzw. erschweren. Eine Optimierung nutzt natürlich nicht zuletzt auch den Besuchern Deiner Webseite.

Duplicate oder Thin Content

Die letzten beiden Punkte sind eigentlich nicht technischer Art, aber ich möchte sie hier nicht unerwähnt lassen. Duplicate Content ist vielen ein Begriff und alle Webmaster wissen, dass das vermieden werden soll. Aber eigentlich ist das nicht ganz so tragisch, wenn der doppelte Content nur auf eigenen Seiten vorhanden ist. Denn man wird nicht "abgestraft", sondern Google sucht sich dann die Seite aus, die am besten zu der Suchanfrage passt. Aber eben nur eine Seite.

Für einen neuen Webshop, der bestimmte Produkte, die schon vielfach in anderen Webshops ähnlich beschrieben und angeboten werden, ist es dann aber sehr schwierig, dass die Produktseiten nochmal indexiert werden.

Wenn man eine neue Webseite hat, deren Inhalte schon auf anderen Webseiten vorhanden sind, kann es mit der Indexierung ggf. mehrere Monate dauern, da Google "denkt", dass die Inhalte schon vorhanden und auch im Index zu finden sind. Hierzu ein Beispiel: Jemand hat sich selbstständig gemacht und in der ersten Zeit noch keine eigene Webseite. Er oder sie hat sich in Branchenverzeichnissen, Linkedin, Xing und / oder anderen Socials mit seinen Daten eingetragen. Dort wird das junge Unternehmen auch durch Google gefunden. Jetzt kommt noch eine Webseite dazu, oft auch noch mit wenig weiterem Inhalt. Da tut sich Google oft schwer, die Seite schnell zu indexieren.

Die Strategie ist dann, dass auf der neuen Webseite der Inhalt mit eigenen Inhalten ausgebaut wird und die anderen Quellen auf die Webseite durch einen Link verweisen. Nützlich ist dann auch dasGoogle Unternehmensprofil. Das würde ich anlegen und ganz wichtig: Die neue Webseite dort hinterlegen.

To-Do-Liste zur Nicht-Indexierung

Hier findet Ihr noch mal alle Punkte zu möglichen Ursachen einer Nicht-Indexierung. Ihr könnt sie der Reihe nachkontrollieren oder auch als pdf-Datei ausdrucken. Viel Erfolg!

Über den Autor

Michael Dilger-Hassel aka Milanex

Seit 2011 habe ich mich als Publisher mit allen Aspekten erfolgreicher Webseiten befasst und bin seit 2015 unter dem Nickname 'Milanex' in mehreren Support Foren zum Thema AdSense und Webmaster aktiv.

Als Google Produktexperte 'Platin' unterstütze ich seit Jahren andere Webmaster ehrenamtlich zu allen Fragen rund um die Google Suche.

In diesem Blog greife ich Fragen aus den Foren auf und nutze meine Erfahrungen für Tipps und Tricks. Einzelne Themen stelle ich ausführlich und vertieft dar, um eine optimale Nutzung Search Console zu ermöglichen, andere Beiträge sind auch für Anfänger:innen geeignet, deren Webseite in der Google Suche gefunden werden soll.

Zur Vita

Bei Anregungen, Kommentaren oder Vorschlägen zum Blogbeitrag: Bitte meldet Euch perE-Mail. Ich freue mich über Rückmeldungen!

Die Indexierung der Webseite: Den Fehlerquellen der Nicht-Indexierung auf der Spur. Mit welchen Tools können die Probleme einer Webseite aufgedeckt werden?

Die Indexierung der Webseite: Den Fehlerquellen der Nicht-Indexierung auf der Spur. Mit welchen Tools können die Probleme einer Webseite aufgedeckt werden?